Comment le passé a le don de vous rattraper, ou

La démocratisation de l’informatique musicale,

10 ans après.

Warren Burt

Traduction de l’anglais: Jean-Charles François[1]

Warren Burt est compositeur, performeur, fabricant d’instruments, poète sonore, cinéaste, artiste multimédia, écrivain et créateur d’œuvres visuelles et sonores…

Sommaire :

1. Introduction – La Conférence internationale 2013 Computer Music

2. 1967-1975 : SUNY Albany et UCSD

3. 1975-1981 : Australie, Plastic Platypus

4. 1981-75 : Micro-ordinateur monocarte à petit budget

5. 1985-2000 : Accessibilité accrue

6. Période post-2000 : L’informalité des trains de banlieue et l’informatique en train sans lieu

7. Aujourd’hui : L’utopie des technologies musicales et les musiciens impertinents

8. Conclusion

1. Introduction – Computer Music, La Conférence internationale 2013

En 2013, l’International Computer Music Conference s’est tenue à Perth en Australie. Le comité d’organisation était présidé par Cat Hope[2], qui a eu la gentillesse de m’inviter à prononcer l’un des discours d’ouverture. Le sujet de mon exposé était la « démocratisation » de « l’informatique musicale ». Je mets ces termes entre guillemets, parce que les deux termes faisaient l’objet de controverses (ils le sont toujours), même si leur signification a peut-être changé, voire beaucoup changé, au cours des dix ans qui viennent de s’écouler. Mon exposé s’est situé dans des perspectives australiennes, parce que c’est là que j’ai vécu la plupart du temps pendant les 47 dernières années. Il s’agissait pour moi de faire comprendre au public de ce colloque international, dans quel contexte particulier celui-ci se déroulait. Le contexte culturel de l’Australie est à certains égards très différent et en même temps très proche de ce qui se passe en l’Europe, en Amérique du Nord, ou dans d’autres parties du monde. Je me souviens de Chris Mann, un poète et compositeur, qui, en 1975, en m’accueillant à l’aéroport lors de ma première visite en Australie, m’a dit, « OK, voici ce qu’il faut savoir : on parle la même langue, mais ce n’est pas la même langue ». Les expériences que j’ai vécues au cours des années suivantes m’ont permis de découvrir, dans les détails les plus exquis, les nombreuses nuances qui différencient l’anglais australien des autres versions de la langue anglaise dans le reste du monde. Et en fait, l’anglais parlé par les Australiens il y a cinquante ans n’est pas celui utilisé aujourd’hui. Je me suis probablement trop habitué à la langue au fil du temps, mais beaucoup des caractéristiques uniques de l’anglais-australien que j’avais remarquées à l’époque ont à présent disparues.

Ce que j’ai voulu montrer à l’époque avait un double objectif : premièrement, que les progrès des technologies rendaient les outils de « l’informatique musicale » plus accessibles à un grand nombre de personnes, et deuxièmement, que la définition de ce qu’on considérait alors comme « informatique musicale » était en train de changer. En 2013, Susan Frykberg[3] m’avait posé la question de savoir si je parlais de « démocratisation » ou bien de « commercialisation » ? Cette question m’avait paru pertinente à l’époque. Depuis lors, la prolifération des téléphones portables et autres objets des technologies numériques qu’on peut tenir dans sa main ont rendu son argument initial moins convaincant qu’hier, même s’il garde aujourd’hui son mordant. Avec « le monde » maintenant complètement unifié par des outils de communication miniaturisés, il semble que les technologies ne sont devenues ni démocratisées, ni commercialisées (ou à la fois démocratisées et complètement commercialisées) mais simplement omniprésentes dans notre environnement culturel continu. Richard Letts, le rédacteur en chef de Loudmouth, un magazine électronique consacré à la musique, vient de me demander d’écrire un article sur l’état actuel des technologies musicales. Pour montrer à quel point le secteur des technologies musicales de pointe était partout répandu, j’ai axé mon article sur les technologies musicales disponibles sur l’iPhone, en montrant que la plupart des applications technologiques musicales sophistiquées du passé étaient désormais disponibles, dans une certaine mesure, sur le plus répandu des appareils électroniques grand public.

Le terme « Informatique musicale » a suivi la même voie. En 2013 il faisait référence à la musique expérimentale utilisant des ordinateurs et aux musiques électroniques populaires [dance musics] fabriquée avec des technologies numériques. Il est clair que le nombre de musiques produites à l’aide des technologies musicales s’est encore élargi. Avec humour, j’ai souligné que le périodique mensuel britannique « Computer Music » publiait surtout des articles de type « mode d’emploi » (« tutoriels ») – pour des personnes produisant de la musique de danse « électro » numérique dans leur chambre à coucher plutôt que des articles traitant des aspects les plus subtiles de la synthèse de pointe. Il y a quelques années, Future Music, l’éditeur britannique de « Computer Music », a racheté le magazine américain « Keyboard » et « Electronic Musician », qui de temps en temps publiait des articles sur des sujets intéressant le monde de « l’avant-garde », et aujourd’hui, les deux publications appartenant à « Future Music » ont non seulement des sphères d’intérêt qui se chevauchent, mais certains articles publiés dans l’un apparaissent également dans l’autre. L’accent continue d’être mis sur la musique de pop/dance réalisée à l’aide des technologies commercialement disponibles, mais au fur et à mesure que le temps passe, certains sujets considérés comme marginaux, tels que la synthèse granulaire, sont désormais abordés dans leurs pages, sans que soit généralement mentionnée les personnes qui ont été les pionniers de ces techniques.

Pour montrer combien le terme « informatique musicale » a changé au cours des ans, j’avais inclus dans mon texte original un bref aperçu de ce que j’avais réalisé au cours du temps en expliquant en quoi ces activités s’inscrivaient ou non, aux différentes époques, dans le cadre de « l’informatique musicale ». Ma démarche se voulait humoristique et en grande partie ironique.

2. 1967-1975: SUNY Albany et UCSD

Il est temps évoquer un peu mon autobiographie. J’ai pu observer combien le terme d’informatique musicale a changé sans arrêt de sens depuis les années 1960. Pour commencer, selon quelle série télévisée on regardait dans notre enfance, on peut aller voir nos chères machines Waybac ou Tardis. En 1967, j’ai commencé mes études à l’Université d’État de New York à Albany [State University of New York at Albany]. Peu de temps après, le département de musique a installé un système Moog de très grande taille conçu par Joel Chadabe[4], sur lequel un dispositif numérique avait été construit par Bob Moog. Ce système permettait divers types de synchronisations et de déclenchements rythmiques. L’Université avait aussi un centre informatique, où l’on pouvait développer des projets impliquant des piles de cartes perforées traitées en temps différé. Je n’étais pas attiré par les cours d’informatique, mais j’ai été immédiatement attiré par le Moog. Au contraire, deux de mes amis étudiants, Randy Cohen et Rich Gold, ont commencé immédiatement à travailler au centre informatique, en déposant leurs piles de cartes perforées et en attendant très longtemps leurs résultats. Si je me souviens bien, Randy avait écrit un programme pour produire de la poésie expérimentale. J’ai été très enthousiasmé par les résultats de sa démarche qui manipulait le sens et le non-sens des mots d’une manière que je trouvais très habile. Randy, qui s’est lancé peu de temps après dans une carrière d’auteur de comédie, pensait au contraire que la quantité de travail nécessaire pour arriver à un résultat que seuls quelques cinglés comme moi pourraient apprécier, n’en valait pas la chandelle. Ainsi, dès le début de mes études, j’ai eu le pressentiment qu’une division existait entre les « musiciens électroniques » et les « artistes de l’informatique » et tout au moins pour le moment, je me plaçais du côté des « musiciens électroniques ».

En 1967, je suis allé faire des études à l’Université de Californie San Diego, et j’ai très vite été impliqué dans les activités du Center for Music Experiment (CME)[5]. Cette structure incluait en son sein des studios de musique analogique et numérique, ainsi que des projets de danse, de multimédia, de vidéo et de performance art. Il y avait un énorme ordinateur[6] tendrement entretenu par plusieurs de mes amis. Ed Kobrin[7] était alors présent avec son système hybride qui comportait un petit ordinateur qui produisait des contrôles de tension pour des modules analogiques. J’étais responsable d’un petit studio qui avait un synthétiseur Serge[8], un système appelé « Daisy », construit par John Roy et Joel Chadabe (un générateur d’information aléatoire très intéressant) et des modules analogiques construits par un autre de mes collègues, Bruce Rittenbach. On pouvait aussi utiliser des tensions de contrôle issus de la sortie de l’ordinateur principal. Mon propre travail consistait pour l’instant à utiliser des « appareils à commandes manuelles », le monde des « lignes de code » étant pour moi encore trop opaque, même si j’avais travaillé sur plusieurs projets où d’autres personnes généraient des signaux de contrôle avec des « lignes de code » pendant que je manipulais les boutons des « appareils à commandes ». J’ai pu aussi faire le constat de la présence d’une division sociale : alors que moi-même et mes amis chanteur et violoncelliste attendions avec impatience la fin de la journée pour nous rendre à la plage Black’s Beach[9], nos amis informaticiens continuaient à travailler sur leur code, généralement tard dans la nuit. À l’époque, le travail sur ordinateur impliquait nécessairement une certaine obsession qui distinguait les « vrais musiciens informaticiens » du reste « d’entre nous ».

En fait, cette distinction s’avère être un peu ridicule, elle rappelle les sempiternels débats sur les « vrais hommes » ou son alternative non sexiste, la « personne authentique ».

Déjà à l’époque, mon intérêt portait sur l’idée de rendre les technologies plus accessibles. Mes amis de SUNY Albany, Rich Gold et Randy Cohen, qui étaient inscrits dans des études postdoctorales au California Institute of the Arts, m’ont fait connaître les travaux de Serge Tcherepnin et son « People’s Synthesizer Project ». L’idée était de pouvoir disposer d’un kit de synthétiseur pour à peu près 700$ qu’un groupe de personnes pouvait assembler. Le faible coût, l’accessibilité et le fait de faire partie d’un collectif étaient des éléments très attractifs. Par ailleurs, le synthétiseur était conçu par et pour des musiciens évoluant dans le cadre de la musique expérimentale. Le projet comportait également une part importante de ce qui allait être connu sous le nom d’autonomisation [empowerment], c’est-à-dire la possibilité de faire les choses par soi-même en complète autonomie. Au même moment, pour mon projet de maîtrise, j’avais commencé à construire un module de circuits électroniques connu sous le nom d’Aardvarks IV. Constitué de circuits numériques, avec des Convertisseurs Numérique à Analogique [DACs, Digital to Analog Converters] que j’avais moi-même bricolés, je l’ai décrit comme « un modèle intégré d’un programme particulier de composition sur ordinateur ». Mon besoin d’avoir des boutons à tourner – c’est-à-dire, d’avoir un dispositif capable d’être contrôlé physiquement en temps réel – restait une préoccupation majeure. Mon approche de la précision numérique était légèrement idiosyncratique. La singularité et le funk faisaient partie de mon esthétique.

Une illustration de ce qu’est le funk dans la conception de circuits électroniques peut s’observer dans la construction des DACs de Aardvarks IV. En suivant les suggestions de Kenneth Gaburo[10] j’ai utilisé des résistances de très basse qualité dans la fabrication des Convertisseurs Numérique à Analogique.

plus d’informations sur Aardvarks IV

Au moment où les Convertisseurs Numérique à Analogique étaient considérés comme des dispositifs utilitaires qui devaient être le plus précis possible, dans la conception de ce module, j’ai essayé de traiter un dispositif utilitaire comme une source de variations et d’imprévisibilité créative. Cet intérêt pour l’imprévisibilité créative probablement me différenciait du reste des copains qui travaillaient dans l’arrière-salle du CME. Et en plus, je préférais aller à la plage Black’s Beach plutôt que de me trouver dans l’arrière-salle.

Les ordinateurs de cette époque étaient des monstres très avides, dévorant toutes les ressources se trouvant à proximité. Maintenant qu’ils ont totalement pris le pouvoir sur nos vies, ils peuvent se permettre d’être plus tolérants, mais en ce temps-là, il s’agissait de la survie du plus fort. Quand j’étais à UCSD, CME ne se limitait pas à la recherche sur l’informatique musicale. Le Centre hébergeait en son sein des projets se situant dans beaucoup de domaines différents. Lorsque ma partenaire, Catherine Schieve[11] est arrivée à UCSD au début des années 1980, le CME multidisciplinaire était en passe de devenir exclusivement un centre des arts informatiques, et elle aussi se souvient d’un fossé social entre les personnes travaillant dans l’informatique et le reste des musiciens et musiciennes. Ce qui différenciait aussi les « types de l’informatique » des autres, c’était la quantité de leur production. C’était encore normal pour une personne travaillant sur ordinateur de travailler de longs mois pour produire une pièce courte. Pour ceux et celles parmi nous qui voulaient produire beaucoup, rapidement, travailler uniquement avec des ordinateurs n’était pas la solution. Éventuellement, l’institution du CME a évoluée pour devenir le CRCA, le « Centre for Research into Computers and the Arts ». En 2013, je suis allé visiter le site internet du CRCA, et je me suis aperçu qu’il avait maintenant de nouveau mis l’accent sur la recherche multidisciplinaire, avec des projets assez passionnants. Cependant, j’ai appris par des personnes travaillant à UCSD en 2013 que depuis, le CRCA avait malheureusement fermé ses portes. Encore une institution qui mord la poussière !

3. 1975-1981 : Australie, Plastic Platypus

Entre à peu près les années 1980 et aujourd’hui, « l’informatique musicale » est devenue un domaine qui regroupe un très large éventail de points de vue esthétiques. Aujourd’hui, pratiquement le seul facteur commun qui unit ce champ d’activité est l’utilisation de l’électricité et, généralement, d’une sorte d’ordinateur (ou circuit numérique). Mais concernant les styles de musique, nous sommes entrés dans une période où « tout est possible ».

À la fin des années 1970 et au début des années 1980 les choses ont changé. De nouveaux ordinateurs de petite taille ont commencé à apparaître et ont été appliqués aux tâches de production musicale. Plusieurs systèmes très prometteurs ont été construits[12] qui ont consisté à fondamentalement dissimuler l’ordinateur derrière une sorte d’interface musicale conviviale. Au même moment, toute une série de micro-ordinateurs ont fait leur apparition, habituellement sous la forme de kits à construire soi-même. Un fossé s’est rapidement creusé dans le monde de l’informatique musicale entre les « personnes de l’ordinateur central » qui préféraient travailler sur les ordinateurs très onéreux qui existaient dans des institutions et les « adeptes de la performance en temps réel » qui préféraient travailler avec leurs propres petits systèmes, microprocesseurs portables, à la portée de leurs moyens financiers. L’ouvrage de Georgina Born, Rationalizing Culture[13], une étude sur la sociologie de l’IRCAM dans les années 1980, a permis de voir comment George Lewis[14], avec son travail sur micro-ordinateur, a réussi à s’insérer dans le monde de l’IRCAM basé sur l’utilisation d’ordinateurs centraux et la présence de structures hiérarchiques.

En 1975, je suis arrivé en Australie. J’ai mis en place un studio de synthèse analogique et de synthèse vidéo à l’Université La Trobe à Melbourne. Dans cette université, Graham Hair[15] a commencé à travailler sur l’informatique musicale sur un ordinateur PDP-11. En poursuivant mes travaux sur « Aardvarks IV » réalisés à UCSD, je me suis remis à travailler avec des puces numériques. Inspiré par ce qu’avait réalisé Stanley Lunetta[16], j’ai conçu un module, « Aardvarks VII » en utilisant exclusivement des puces compteur/diviseur 4017 et gate puces 4016. Il s’agissait de la forme de conception numérique la plus rudimentaire. Les puces étaient simplement soudées sur des cartes de circuits imprimées. En d’autres termes, la façade en plastique du synthétiseur comportait les connexions de circuit imprimées à l’arrière, et les puces étaient directement soudées sur ces connecteurs imprimés. Pas de mise en mémoire tampon, rien d’autre. Juste des puces. Il était principalement conçu pour travailler avec des fréquences accordées en intonation juste et il m’a permis de jouer avec beaucoup plus de modules. Tout cela en temps réel. L’esthétique du patching restait pour moi le paradigme, basé sur la manipulation physique en temps réel et sur des modules combinatoires. À cette époque, en 1978-79, j’avais l’impression d’être devenu un musicien électronique qui travaillait avec des circuits numériques, mais je n’étais pas encore cette bête rarissime qu’est le « musicien informaticien ».

Simultanément, j’ai été amené à utiliser la technologie la plus rudimentaire – c’est-à-dire l’électronique grand public la moins chère, au bas de l’échelle économique – pour faire de la musique. Ron Nagorcka[17] (que j’avais rencontré pour la première fois à UCSD) et moi-même nous avons formé un groupe nommé Plastic Platypus qui faisait de la musique électronique vivante avec des magnétophones à cassette, des jouets et de la camelote électronique [electronic junk]. Certaines de nos installations étaient très sophistiquées, la nature low-tech et low-fi de nos outils dissimulant une pensée systémique très complexe, mais notre travail est né d’un questionnement idéologique sur la nature de la haute-fidélité. Alors qu’à l’occasion, il était pour nous très agréable de travailler dans des institutions qui pouvaient se payer des haut-parleurs de qualité (etc.), nous étions aussi conscients que les coûts des systèmes audiophiles étaient hors de la portée de beaucoup de gens. Étant donné que l’une des principales raisons pour lesquelles nous avons créé le groupe était de travailler sur les types d’équipement les plus courants afin de montrer que la musique électronique pouvait être accessible au plus grand nombre, nous avons adopté la qualité sonore du magnétophone à cassette, du minuscule haut-parleur suspendu à un fil se balançant, celle du piano jouet ou du xylophone jouet. Comme le disait Ron avec éloquence, « l’essence-même des médias électroniques c’est la distorsion ». La technologie, bien sûr, à la longue allait nous rattraper et l’accès des « masses » à une bonne qualité sonore est devenue une question sans objet vers la fin des années 1980, mais notre travail sérieux avec les problèmes et joies de la technologie de basse qualité entre temps nous a beaucoup amusé.

Ron et moi (et plusieurs autres personnes qui travaillaient alors avec la technologie des cassettes, comme par exemple Ernie Althoff[18] et Graeme Davis[19]) on était généralement d’accord sur la manière d’envisager l’utilisation de cette technologie. Un processus de feedback multigénérationnel, tel que celui illustré dans l’œuvre d’Alvin Luciers, « I Am Sitting in a Room »[20], était à la base d’une grande partie de nos productions. Dans ce processus, un son est produit sur une machine et enregistré simultanément sur une deuxième machine. La seconde machine est ensuite rembobinée et la lecture de cette machine est enregistrée sur la première machine. En répétant plusieurs fois ce processus, il en résulte d’épaisses textures sonores, entourées d’une rétroaction acoustique qui s’accumule progressivement. Dans la pièce de Ron « Atom Bomb », pour deux interprètes et quatre magnétophones à cassette, il a eu l’idée d’ajouter l’action d’avance et de retour rapides des cassettes en cours de lecture pour créer une distribution aléatoire dans le temps des sources sonores au fur et à mesure qu’on les enregistrait. A la fin de cette section, les quatre cassettes étaient rembobinées et rediffusée aux quatre coins de la salle, créant ainsi une « pièce pour bande électroacoustique » quadriphonique que le public avait vu assemblée devant lui. Dans ma pièce « Hebraic Variations », pour alto, deux magnétophones à cassette et haut-parleur portable attaché à une très longue corde, je jouais (ou essayait de jouer) la mélodie de « Summertime » de George Gershwin (je suis un altiste de niveau très insuffisant). Pendant que je jouais la mélodie en boucle sans fin, Ron enregistrait à peu près 30 secondes de mon jeu sur un magnétophone à cassette (« l’enregistreur »), puis il transférait cette bande sur une deuxième machine (le « lecteur »), recommençait à enregistrer sur la première machine, et puis faisait tourner en cercle au-dessus de sa tête le haut-parleur de la seconde machine pendant à peu près une minute. Cela créait des décalages Doppler et une texture plus épaisse par rapport à mon jeu sur l’alto. Après 5 ou 6 cycles de ce procédé, un paysage sonore d’une très grande densité était assemblé, constitué par des glissandi, des notes pas très justes et de nombreux types de clusters sonores. La médiocrité de la technologie liée à celle de ma production se multipliaient mutuellement, créant un monde sonore micro-tonal épais.

L’entente entre Ron et moi dans l’élaboration du répertoire de Plastic Platypus a été presque unanimement parfaite. La composition des pièces a été laissée à la responsabilité de chacun, et ensuite les désirs de chaque compositeur ont été pris en compte du mieux possible. Le niveau de confiance et d’accord entre nous était très élevé. Il y deux ans, Ron a retrouvé des cassettes des performances de Plastic Platypus, il les a copiées et me les a envoyées. Beaucoup de nos anciens moments favoris étaient présents et étaient instantanément reconnaissables. Mais de temps en temps, nous avons été désarçonnés tous les deux à l’écoute d’une pièce – on n’arrivait pas à déterminer qui avait composé la pièce ou à quelle occasion elle avait été enregistrée. Ces pièces étaient peut-être des improvisations qui, par les processus utilisés, obscurcissaient l’identité de qui en était l’auteur.

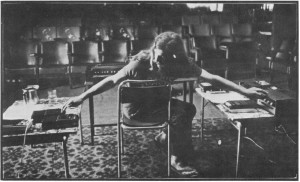

Ron Nagorcka au Clifton Hill Community Music Centre, 1978

En plus de mes travaux sur les synthétiseurs analogues, de la fabrication de mes propres circuits numériques et de mes travaux avec la low-tech, j’ai alors commencé à m’impliquer sérieusement dans l’informatique[21]. Lors de mes séjours aux Etats-Unis, Joel Chadabe m’a permis de travailler gracieusement dans son studio et pour la première fois, j’ai effectivement utilisé un code pour déterminer des évènements musicaux. Les résultats étaient produits presque en temps réel, ce qui donnait satisfaction au « tourneur de boutons » que j’étais. Plus tard, de retour en Australie, en 1979, j’ai travaillé sur le Synclavier à l’Université d’Adélaïde à l’invitation de Tristam Cary[22] et en 1980, à Melbourne, j’ai demandé à avoir accès au Fairlight CMI au Victorian College of the Arts et j’ai appris tous les tenants et les aboutissants de cette machine. J’ai contracté le virus de posséder mon propre système informatique[23]. Mon choix s’est porté sur un micro-ordinateur Rockwell AIM-65. Je me suis donc plongé dans l’apprentissage de cette machine et j’ai construit pour cela ma propre interface de manière extrêmement idiosyncratique. Ensuite, ayant élargi la mémoire du AIM à 32k, j’étais super excité [I was hot]. Il était maintenant possible de réaliser de la synthèse des sons en temps réel (en utilisant des formes d’ondes dérivées du code dans la mémoire). En utilisant le AIM-65 de cette façon et en traitant sa sortie avec le Serge, je pense que j’étais finalement devenu un « musicien informaticien », mais je ne sais pas si j’en étais un « véritable ». Plus précisément, mon approche restait toujours idiosyncratique, et mon penchant pour rendre l’équipement plus accessible à tous en donnant en exemple ma propre démarche (un marxiste aurait un mouvement de répulsion à cette idée) semblait, au moins dans ma tête, me distinguer encore de mon homme de paille mythique, l’élitiste, obsédé par la perfection et la répétabilité, opérateur d’ordinateurs institutionnels qui ne veut toujours pas aller à la plage.

4. 1981-75 : Micro-ordinateur monocarte à petit budget

Mes aventures avec le micro-ordinateur mono-carte pas cher m’ont occupé par intermittence pendant les années 1981-85[24]. Les travaux réalisés avec ce système entre 1982 et 1984 ont été regroupés sous le titre d’Aardvarks IX. Un des mouvements a été nommé « Three Part Inventions (1984) ». Il s’agissait d’une pièce semi-improvisée dans laquelle j’utilisais le clavier de mon ordinateur comme un clavier musical. Programmé en FORTH, j’étais capable de réaccorder le clavier sur n’importe quelle gamme micro-tonale en appuyant sur une touche[25]. Dans cette pièce, je combinais mes capacités de « musicien informaticien » avec mon intérêt pour la technologie démocratisée grâce à des coûts abordables et mon intérêt pour les formes de diffusions musicales non publiques. Chaque matin (je pense que c’était en juin 1984) je m’asseyais et j’improvisais une version de la pièce, en enregistrant cette improvisation du matin sur une cassette de haute qualité. Je pense que j’ai réalisé 12 versions uniques de la pièce de cette manière. J’ai aussi réalisé encore une autre version de la pièce, que j’ai enregistrée sur un magnétophone à bobines et je l’ai gardée pour l’utiliser dans la version enregistrée de l’ensemble du cycle. Chacune des 12 versions uniques de la pièce a été envoyée en cadeau à une de mes connaissances. Bien sûr, je n’ai pas gardé trace de quelles versions j’avais amicalement envoyé aux 12 personnes. C’est ainsi que dans cette pièce, j’ai pu combiner mon intérêt pour les systèmes d’intonation micro-tonale, l’improvisation, les processus électroniques en temps réel, l’utilisation des technologies bon marché (ou moins chères) (l’ordinateur AIM et le magnétophone à cassettes), l’art par courrier postal personnel, et les réseaux non publics de distribution de la musique, tout ceci intégré dans une seule pièce. J’ai voulu tout avoir – une recherche sérieuse high-tech et des réseaux d’édition et de distribution prolétaires, réalisés avec des circuits électroniques fabriqués à la maison et une informatique de niveau amateur. Il n’a pas été surprenant de constater que certains de mes amis se situant dans la « sphère haute » de « l’informatique musicale » aient exprimé un certain nombre de points de divergence concernant mes choix dans cette pièce d’instrument, de performance et de diffusion.

Quelques questions à l’époque semblaient pertinentes et, dans une certaine mesure, elles le sont encore aujourd’hui. Une des questions est : « À quel point est-on prêt à construire la totalité des choses par soi-même de la cave au grenier ? » Je pense que la raison pour laquelle on voulait effectuer ce travail de construction était que les équipements étaient onéreux et surtout confinés dans les institutions. Aujourd’hui, on dispose d’un éventail de possibilités allant d’applications limitées ne faisant qu’une seule chose correctement (avec un peu de chance) à des projets dans lesquels on construit soi-même ses propres puces et leur mise en œuvre. Même si les exemples que j’ai donnés sont un peu extrêmes, il s’agit là de l’éventail des choix qui s’offraient à nous à l’époque : le bricolage artisanal ou bien le prêt-à-porter sur catalogue, et dans quelle proportion ?

Une autre question concernait la notion de propriété. Était-on dans la situation d’utiliser les outils de quelqu’un d’autre, que ce soit ceux d’une institution à laquelle on était associé ou l’équipement d’un ami lors d’une visite chez lui ? Ou bien était-ce la situation d’utiliser ses propres outils qu’on avait été capable de développer dans une relation de longue durée ? À ce stade de ma vie, je faisais les deux à la fois. Encouragé par l’exemple de Harry Partch[26],qui pendant mes années à UCSD (1971-75) était encore en vie et installé à San Diego et directement encouragé par mon professeur Kenneth Gaburo, j’ai pris la décision que, même s’il était possible de prendre avantage des facilités offertes par les institutions si elles étaient disponibles, je préférais posséder mon propre équipement. Ce qui voulait dire que j’étais disposé à ce que l’ensemble de mes activités soit déterminé par mon pouvoir d’achat. Ainsi, une exploration intense de la micro-tonalité était rendue possible par les outils disponibles à bas prix (ou que j’avais la capacité de construire), mais une exploration sérieuse du son multicanal n’était pas à l’ordre du jour, parce que je ne pouvais me payer ni l’espace ni les haut-parleurs qu’on pouvait trouver pour cet usage. Pourtant, j’ai pu réaliser des projets utilisant à la fois des haut-parleurs peu orthodoxes et de la spatialisation sonore. Voici deux photos du Grand Ni, une installation à l’Experimental Foundation, Adelaïde (Australie).

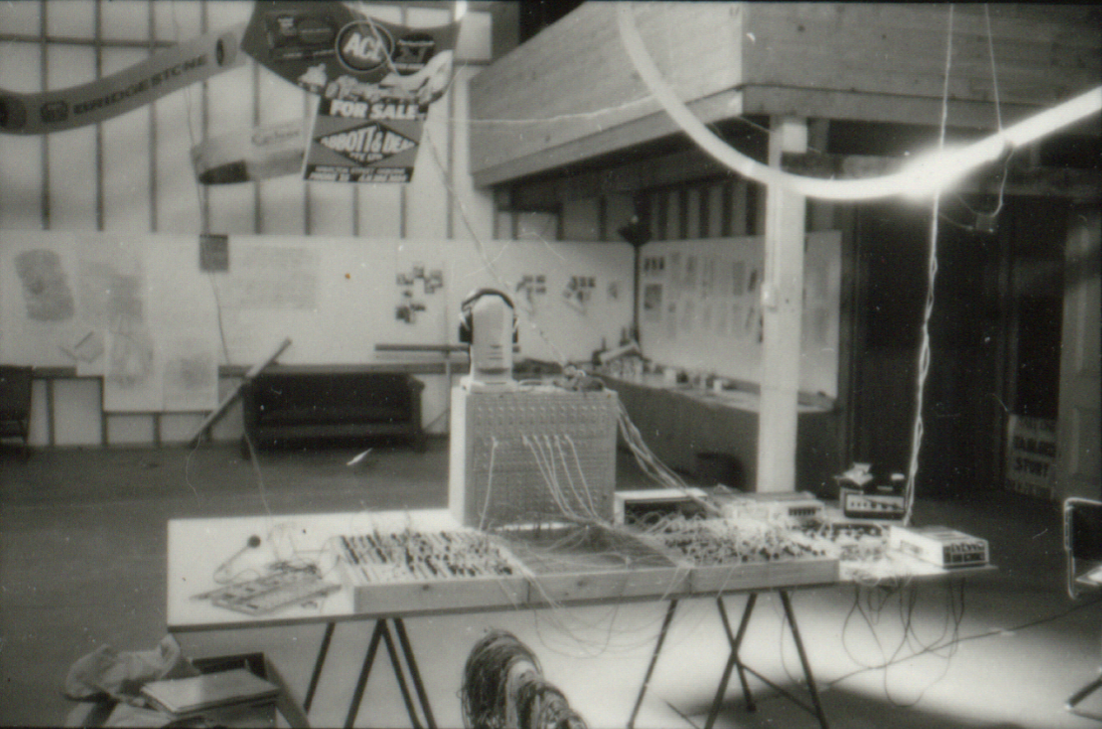

Warren Burt : Le Grand Ni, Experimental Art Foundation, Adelaïde, 1978, Aardvarks IV (la boîte argentée verticale).

Aardvarks VII (le panneau plat placé devant Aardvarks IV), transducteurs attachés à des panneaux publicitaires en métal utilisés comme haut-parleurs.

Photo : Warren Burt.

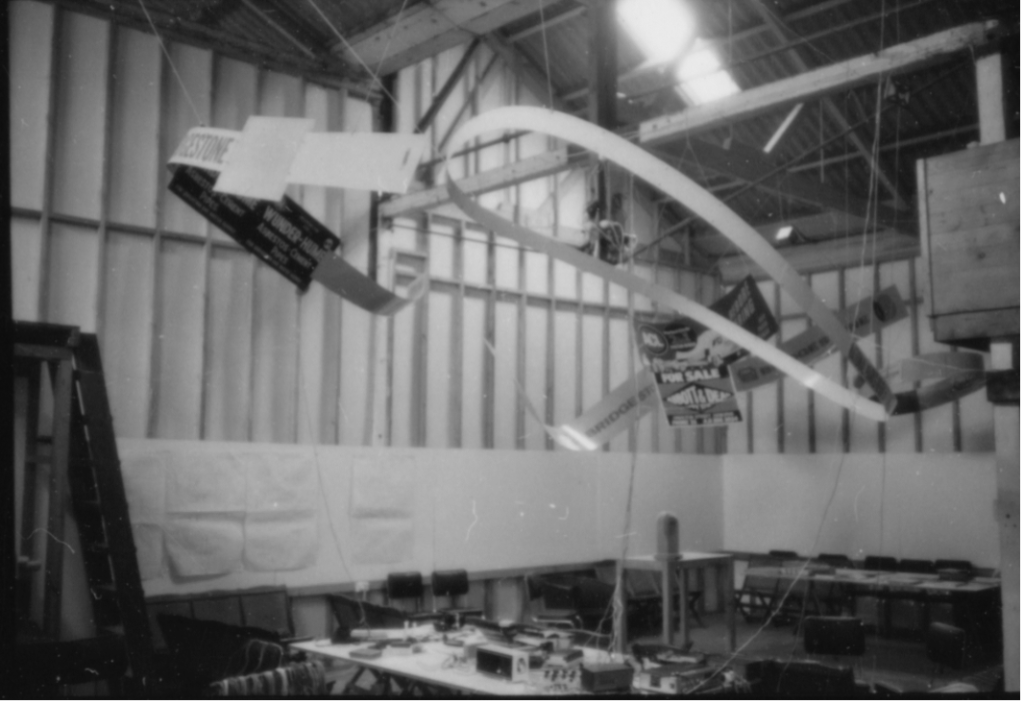

Le Grand Ni, 1978 – vue sur les panneaux en métal utilisés comme haut-parleurs.

Photo : Warren Burt.

Voici un extrait du 5ème mouvement du Grand Ni. Ce mouvement est diffusé par des haut-parleurs normaux, pas par les haut-parleurs en sculpture métallique :

Warren Burt, « Le Grand Ni », extrait du 5ème mouvement.

Plus récemment, j’ai eu peu d’opportunité de réaliser des travaux impliquant des systèmes de son multicanaux, car je n’ai pas été en situation d’avoir accès à des espaces et du temps pour le faire, mais il y a peu, j’ai reçu une commission du MESS, le Melbourne Electronic Sound Studio, pour composer une pièce pour leur système de son à 8 canaux. Cela a eu lieu en septembre-octobre 2022 et le 8 octobre 2022 à la SubStation, à Newport dans l’Etat de Victoria, j’ai présenté la nouvelle œuvre pour 8 canaux en concert. (Merci beaucoup à MESS pour m’avoir donné l’opportunité de réaliser ce projet et pour l’assistance fournie).

Une autre raison pour disposer de son propre équipement a été – au moins en ce qui me concerne – la nature fragile des relations que j’ai pu avoir avec les institutions. Comme beaucoup d’entre nous, nous avons été mis dans la situation de consacrer plusieurs années à développer des équipements institutionnels, pour ensuite perdre notre emploi dans cette institution. Cette situation en Australie est de plus en plus grave. La plupart des personnes que je connais qui travaillent dans les institutions universitaires ne sont plus que des vacataires avec des contrats renouvelables à l’année. Même le statut « d’employé permanent », déjà fort éloigné des positions avec garantie d’emploi à vie, mais qui est au moins quelque chose, semble être de moins en moins offert. Quant aux Teaching Assistants [étudiants de troisième cycle servant d’assistants à un membre de la faculté] ce n’est plus la peine de les mentionner – ils n’existent plus. En 2012, dans le cadre de mon emploi, j’ai dû faire de la recherche concernant l’état de l’enseignement des technologies musicales en Australie. J’ai découvert qu’à l’échelle nationale, dans la période 1999-2012, 19 institutions avaient soit supprimé leur programme de technologies musicales ou en avaient sévèrement réduit leur budget. Cela ne s’est pas seulement produit dans les petites institutions, mais les grands établissements ont été aussi partout impactés. Par exemple, quatre des principaux chercheurs en informatique musicale travaillant en Australie, David Worrall, Greg Schiemer, Peter McIlwain, et Garth Paine ont tous été licenciés des institutions qu’ils avaient contribué à développer pendant de nombreuses années. Notons qu’il ne s’agit pas de personnes ayant quitté volontairement leur poste universitaire avec un remplacement par une autre personne dans la foulée, mais ce sont les postes aux-mêmes qui ont été supprimés. Étant donné cette situation, ma décision prise il y a plusieurs dizaines d’années de « posséder mon propre studio » est aujourd’hui plus sage que jamais.

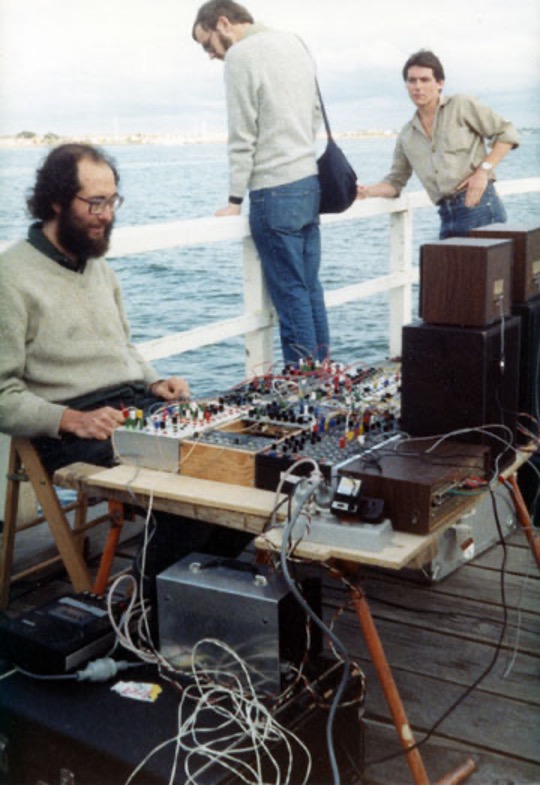

Voici une photo qui donne un exemple des résultats de mon « adresse au citoyen » au début des années 1980. Les sons produits lors de la performance incluaient : 1) Cliquetis de crevettes ; 2) Sons électroniques (à hauteurs déterminées) en réponse aux crevettes ; 3) Sizzzz de sons sous-marins de bateaux à moteurs ; 4) Vagues ; 5) Un gong trempé dans de l’eau ; 6) Tortillements d’oscillateurs retraçant l’amplitude de la production sonore d’un hydrophone ; 7) « La Mer » de Debussy jouée sous l’eau et traitée par les vagues ; 8) Les sons produits par le public ; 9) Mes paroles s’adressant au public ; 10) Mouettes. Cette performance qui a duré toute la journée a eu lieu au Festival de St Kilda[27], évènement orienté vers la large participation du public, sur la jetée de St Kilda en 1983.

Adresse aux « citoyens » : Warren Burt: Natural Rhythm 1983. Hydrophone, water gongs,

Serge, Driscoll et modules bricolés à la maison, Gentle Electric Pitch to Voltage, haut-parleurs Auratone.

St. Kilda Festival, St. Kilda Pier, Melbourne.

Photo : Trevor Dunn.

Au milieu des années 1980, j’ai changé : j’ai commencé à utiliser des ordinateurs commerciaux. J’avais démissionné de l’université à la fin de 1981, et en tant que musicien indépendant, j’avais besoin d’un ordinateur moins onéreux. Le AIM-65 single-board micro-ordinateur que j’ai utilisé de 1981 à 1985, s’est éventuellement avéré ne pas être assez puissant, ni assez fiable, pour ce dont j’avais besoin. Une série de machines basées sur PC-Dos a alors suivi. Pendant tout ce temps-là, j’ai continué à m’intéresser à composer et à utiliser des systèmes de synthèse de manière non conventionnelle. Je me suis beaucoup amusé pendant un certain temps sur US, développé par les Universités d’Iowa et d’Illinois. Wigout de Arun Chandra[28] – une reconstitution de « Sawdust » d’Herbert Brün[29] – s’est avéré également une précieuse ressource. J’ai observé avec enthousiasme mes amies et amis en Angleterre, motivées par la même « éthique de la pauvreté et de l’enthousiasme-pour-l’accessibilité » à laquelle j’adhérais, développer le Composers’ Desktop Project, même si je n’ai pas réellement utilisé le CDP système avant un certain temps. J’ai étudié des programmes plus anciens quand ils étaient disponibles, tels que le PR1 de Gottfried-Michael Koenig [30] qui s’est avéré fertile pour quelques pièces de la fin des années 1990. Et je me suis trouvé dans la situation de m’impliquer avec des développeurs de logiciel et j’ai commencé à faire des tests bêta pour les aider. John Dunn (1943-2018) d’Algorithmic Arts a été l’un de mes plus constants collègues de travail pendant à peu près 23 ans, et j’ai créé un certain nombre d’outils disponibles sur ses programmes SoftStep, ArtWork et Music Wonk.

5. 1985-2000 : Technologies plus accessibles<

William Burroughs raconte une anecdote très amusante dans une de ses histoires au sujet d’un voyageur malheureux qui est invité par la Green Nun[31] à « voir le merveilleux travail effectué avec mes patients dans le service psychiatrique ». En entrant dans l’institution son comportement change. « À tout moment, vous devez obtenir la permission pour quitter la pièce ». Etc. Et donc les années ont passé. En ayant conscience du temps qui passe, on arrive maintenant au présent et ce qu’on voit c’est une corne d’abondance de dispositifs pour faire de la musique, de programmes (etc.), tous disponibles à bas coûts, etc.

À un certain moment dans les années 1980, les ordinateurs sont devenus plus petits et ils ont été dotés d’une foison de boutons et de capacités en temps réel, et ont cessé d’être le domaine exclusif de quelques personnes ayant accès à des studios bien dotés pour devenir accessible à pratiquement toutes les personnes intéressées. À condition évidemment d’avoir les connaissances adéquates, le statut social, etc. Et dans cette idée d’un ordinateur avec une pléthore de boutons de contrôle, j’aime bien la conception de l’interface du GRM [Groupe de Recherche Musicale] Tools en France. « Tools » en France. En suivant les idées de Pierre Schaeffer, ce qui a primé dans la conception de ce logiciel, c’est le fait de pouvoir contrôler tous les paramètres de l’extérieur, d’avoir beaucoup de possibilités de passer en douceur d’un réglage à un autre, et d’éviter d’avoir à manipuler une grande quantité de nombres dans le feu de l’action.

À un certain moment, vers (peut-être) la fin des années 1990, le nombre d’oscillateurs mis à disposition n’était plus un problème. La question de l’accessibilité s’est concentrée dès lors sur les moyens de contrôler un grand nombre d’oscillateurs. Je me souviens qu’Andy Hunt à l’Université de York travaillait sur Midigrid, un système mis à la disposition des personnes handicapées pour contrôler les systèmes de musique électronique par rapport à leur mobilité réduite. Le développement de ce système s’est arrêté en 2003. Il se trouve que cette année, une entreprise anglaise, ADSR Systems, a mis sur le marché un produit appelé Midgrid. Au vu de leur vidéo YouTube, je ne pense pas que les deux logiciels ont quoi que ce soit en commun. Et ces deux dernières années, l’équipe du AUMI – Adaptive Use Musical Instruments [Instruments de musique à utilisation adaptée][32] ont fait des avancées considérables pour développer des systèmes de contrôle de la musique pour les tablettes et ordinateurs portables qui rendent l’accès aux contrôles encore plus facile.

De plus, au cours des années 1990, l’accès à la qualité de la diffusion sonore (l’économie de la haute-fidélité) a cessé d’être un problème. C’est-à-dire, la question du désir et du confort est devenue plus importante que les aspects économiques. Les prix des équipements se sont écroulés, pour moins cher, on peut avoir de plus en plus de puissance. De nouveaux paradigmes d’interaction ont fait leur apparition, tels que l’écran tactile et d’autres nouveaux dispositifs de performance, et à peu près tout ce qu’on peut espérer avoir est maintenant disponible à un prix relativement bas. En face de cette abondance, on peut être déconcerté, accablé ou enchanté et se plonger dans l’utilisation de tous ces nouveaux outils, jouets et paradigmes mis à disposition.

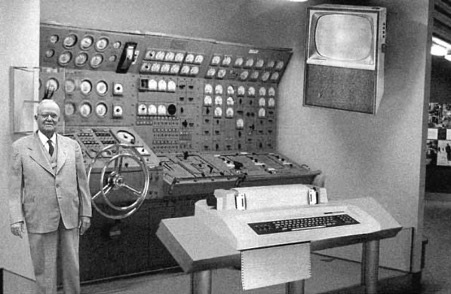

Voici quelques photos qui illustrent certains des changements qui ont eu lieu pendant la brève histoire de « l’informatique musicale » :

John Cage, Lejaren Hiller et Illiac 2, University od Illinois, 1968, en train de travailler sur HPSCHD.

Les coulisses d’un salon professionnel, Melbourne 2013.

Chacune des tablettes Android travaillant à la sortie de l’ordinateur portable est plus puissante qu’Illiac 2

et coûte infiniment moins cher.

Photo : Catherine Schieve.

Dispositif informatique par Warren Burt pour « Experience of Marfa » de Catherine Schieve.

Concerts Astra, Melbourne, 1-2 juin 2013.

Deux ordinateurs portables et deux netbooks contrôlés par des unités de contrôles Korg.

Photo: Warren Burt.

Une autre vue du dispositif informatique de « Experience of Marfa ».

Notez le gong et l’orchestre artisanal de Surti Box derrières les ordinateurs.

Photo : Warren Burt.

Cette photo est pour rire.

Il s’agit d’une photo de 1954 de la RAND Corporation montrant comment on pouvait imaginer

à quoi ressemblerait l’ordinateur domestique standard en 2004.

6. Période post-2000 : L’informalité des trains de banlieue et l’informatique en train sans lieu

Il y a une ressource néanmoins qui déjà coûtait cher à l’époque, et qui l’est encore plus aujourd’hui. Cette ressource, c’est le temps. Le temps d’apprendre les nouveaux outils/jouets, le temps pour composer des pièces avec les jouets, le temps pour écouter les travaux des autres personnes et que les autres puissent écouter nos œuvres. En Australie, les conditions de travail se sont détériorées et les dépenses ont augmenté, de sorte qu’il faut maintenant travailler plus longtemps pour disposer de moins de ressources. L’époque semble révolue, du moins pour le moment, où l’on pouvait travailler trois jours de la semaine pour gagner assez d’argent pour exister et pouvoir disposer de quelques jours pour travailler sur sa production artistique. Dans notre société complètement dominée par l’économie, le temps consacré à des activités non économiques devient un véritable luxe. Ou bien, comme Kyle Gann l’a exprimé avec éloquence dans son blog Arts.Journal.com Post Classic, blog du 24 août 2013 :

En bref, nous sommes tous, chacun d’entre nous, en train d’essayer de discerner quel genre de musique il est possible de produire de manière satisfaisante, signifiante et/ou utile socialement dans le contexte d’une oligarchie contrôlée par le monde de l’entreprise. Il y a une myriade de réponses possibles, chacune ayant ses avantages et ses inconvénients sans qu’il y ait pour le moment de preuves d’un côté comme de l’autre. Nous conservons notre idéalisme et faisons le mieux que nous pouvons.

Un autre facteur de l’érosion de notre temps disponible est l’expansion des médias de communication. Je ne sais pas ce qu’il en est pour vous, mais sauf si j’éteins mon portable et mon courrier électronique, il est très rare qu’il y ait une période de plus d’une demi-heure où quelque chose ne réclame pas mon attention urgente, que ce soit sous la forme d’un texte, d’un coup de téléphone, ou d’un courriel. Cet état d’interruption constante du temps de travail, qui ne cesse de diminuer, est la situation dans laquelle beaucoup d’entre nous se trouvent.

Ma propre solution a été d’investir dans l’achat d’un casque supprimant les bruits et d’ordinateurs portables petits mais assez puissants, et après 2016, dans des tablettes, telles que l’iPad Pro, pour pouvoir travailler dans les excellents trains de banlieue de l’État de Victoria. Quand on est entouré de 400 personnes, que le modem est éteint, et que le casque nous empêche d’entendre le téléphone portable, alors on peut disposer d’au moins une heure, à l’aller comme au retour, pour se consacrer de manière ininterrompue à la composition. Cependant, je me demande bien quel est l’effet sur ma musique lorsqu’elle est composée dans un environnement aussi confiné, étroit et hermétique. Je continue à composer de cette manière et j’ai écrit beaucoup de pièces dans cet environnement. Dans cette pièce, « A Bureaucrat Tells the Truth » [Un bureaucrate dit la vérité] tirée des « Cellular Etudes » (2012-13) je combine des échantillons sophistiqués avec des sons bruts à 8 bits reconstruits avec amour dans le softsynth Plogue, Chipsounds :

Warren Burt, « A Bureaucrat Tells the Truth »

J’ai envoyé cette pièce à David Dunn et voici ses observations :

Une des questions formelles qui m’est venue à l’esprit a été l’idée que les échantillons sonores pour le contrôle midi sont des objets trouvés (de la même manière que tout instrument musical est un objet trouvé) qui portent en eux des constructions culturelles particulières (la tradition). La plupart des compositeurs veulent habituellement qu’une pièce se situe dans une ces traditions (bourges vs. Stanford vs. cage vs. orchestre occidental vs. musiques du monde vs. musiques bruitistes vs. jazz vs. musique spectrale vs. rinky-dink lo-fi diy etc.). C’est le cas généralement de compositeurs qui essaient de limiter leurs choix de timbres de manière à définir un contexte d’association particulier (genre). Dans ces pièces on laisse les cultures divergentes se frotter le nez jusqu’à ce qu’elles saignent. Et c’est vrai. Je veux jouer sur les deux tableaux, ou peut-être sur tous les tableaux. Je ne vois rien de mal à être à la fois hi-tech et lo-tech, à être à la fois complexe et élitiste, ET prolétaire.[33]

Peut-être que ma méthode de composition dans le confinement et l’isolement du train me fait accumuler côte à côte de plus en plus de cultures, tout comme ces personnes dans ce train, issues de tant de cultures, qui se serrent les unes à côté des autres.

La question du temps est donc plus que jamais un problème. L’une des raisons en est l’accélération sur le marché de la mise à disposition de matériels, qui dépasse de beaucoup ma capacité à les interroger sérieusement. L’une de mes stratégies pour composer consiste à étudier un appareil ou un logiciel et de me demander, « Quels en sont les potentiels pour la composition ? » Pas tellement « pour quel usage a-t-il été conçu », mais plutôt « comment peut-il être subverti ? » Ou bien si cela paraît trop romantique, peut-être de se demander, « Qu’est-ce que je peux faire avec cet outil que je n’ai pas déjà fait ? » Et « Quelle est la Structure Profonde contenue dans cet outil ? » En me souvenant des premières années de la musique électroacoustique, quand des gens comme Cage, Grainger et Schaeffer ont utilisé des équipements clairement conçus pour d’autres usages que celui de produire de la musique, je me trouve dans une situation similaire aujourd’hui. Le meilleur magasin de nouvel équipement musical que j’ai trouvé à Melbourne est StoreDJ, qui propose une bonne sélection, des prix modiques et un personnel connaisseur. Alors que Cage et ses amis se procuraient leur équipent dans le monde de la science et de l’armée, je trouve maintenant que je peux me procurer certaines de mes ressources dans l’industrie de la dance-music. Dans une période très récente (2020-22) je me suis impliqué dans la communauté VCV-Rack. Il s’agit d’un groupe de programmeurs, sous la direction d’Andrew Belt (voir aussi Rack 2) qui a construit des modules virtuels qui peuvent être assemblés ensemble, comme les modules analogues étaient utilisés (ils le sont encore aujourd’hui) pour créer des systèmes de composition complexes. J’ai contribué au projet NYSTHI d’Antonio Tuzzi qui fait partie du projet VCV, avec certaines de mes conceptions de circuits. On peut avoir accès à 2500 modules, certains d’entre eux étant des copies de logiciels de modules physiques existants, et d’autres sont des créations originales et uniques qui ouvrent la voie à l’exploration de nouveaux potentiels compositionnels. La distinction évoquée ci-dessus, entre l’industrie de la dance-music et les ressources mises à la disposition du monde de la « musique contemporaine » ou de la « musique expérimentale » a maintenant largement disparue. Il y a tant de nouvelles ressources disponibles, provenant de toutes sortes de concepteurs, avec toutes sortes d’orientations esthétiques, qu’on est submergé par la diversité des choix à faire.

Il y a deux ans j’ai dit en plaisantant qu’il y avait beaucoup trop de post-doctorants japonais dans les écoles d’ingénieurs du son avec beaucoup trop de temps libre pour créer de nombreux plug-ins gratuits intéressants, si bien qu’ils ne me laissaient que peu de possibilités d’être capable de tous les suivre. Maintenant, bien sûr, la situation s’est empirée considérablement, est-ce une bonne chose ? La quantité de ressources disponibles gratuitement, ou à très bas prix, dans le projet VCV Rack ou dans l’écosystème de l’iPad, est telle que je pourrais y passer plusieurs de mes prochaines vies. Et aussi longtemps que je serais capable d’avoir une ouverture d’esprit et une attitude expérimentale, ce sera probablement le cas.

Voici des liens pour regarder deux vidéos, montrant des travaux réalisés il y a une dizaine d’années. La première, « Launching Piece » utilise 5 tablettes numériques[34]. À l’époque, je venais juste de commencer à travailler avec cette installation, et c’était très agréable de sortir de la situation d’être « derrière l’écran de l’ordinateur », et de pouvoir d’avantage s’engager physiquement pendant la performance. Je suis très attaché à ce que Harry Partch appelait la « nature spirituelle et corporelle de l’être humain »[35] fasse intégralement partie de la pratique musicale. La seconde, « Morning at Princess Pier » utilise un iPad dont le son est traité par un vénérable Alesis AirFX pour produire une série d’accords microtonaux ayant une fluidité de timbre. Et en guise de choc du futur (parlons-en !), quand j’ai acheté le AirFX en 2000, je me souviens de m’être moqué de leurs slogans publicitaires – « Le premier instrument de musique du 21e siècle ! » et « parce que maintenant, tout le reste est tellement 20e siècle ! ». Dans les deux pièces, les nouvelles ressources m’ont enfin permis de retrouver une implication plus physique dans ma prestation musicale..

Vidéo

Warren Burt “Launching Piece”

Vidéo

Warren Burt,

“Morning at Princes Pier”

7. Aujourd’hui, qu’en est-il de l’utopie des technologies musicales et des musiciens impertinents ?

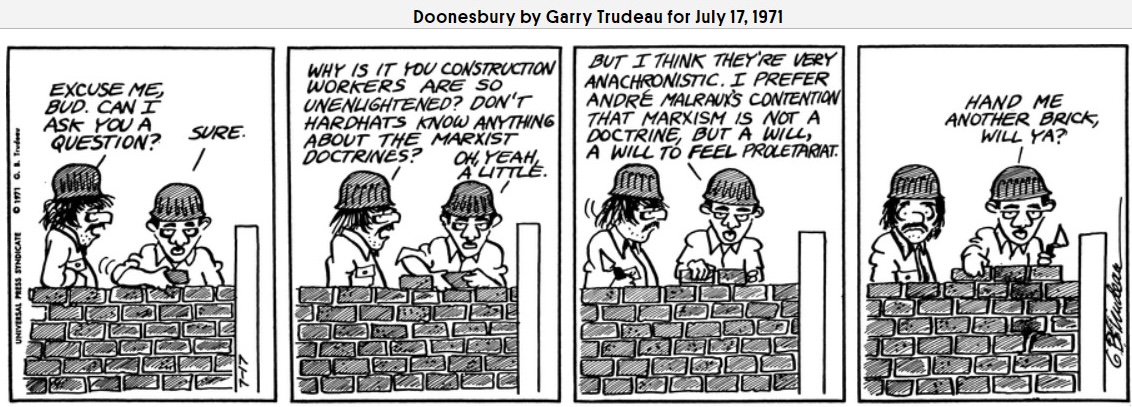

J’ai un ami qui est aussi audiophile. Il a un merveilleux système de diffusion sonore avec lequel il passe beaucoup de temps d’écoute. Je lui ai proposé l’idée qu’être audiophile était une activité élitiste, à la fois par rapport au coût des équipements et du fait qu’il pouvait se permettre de prendre le temps d’écouter attentivement les choses. Je lui ai demandé s’il était capable de concevoir un système sonore audiophile que la classe ouvrière pourrait se payer – autrement dit, s’il pouvait concevoir un système sonore audiophile prolétarien. Sa réponse a été grandiose : « Pour qui ? Pour les gens qui dépensent 2000$ pour une télévision à écran plat ? » J’ai dû admettre qu’il avait raison. Les « classes populaires » peuvent dépenser beaucoup d’argent pour se procurer les équipements nécessaires aux divertissements qu’elles souhaitent. Et j’ai décidé que tout comme André Malraux quand il disait qu’il pensait que le marxisme était une volonté de ressentir, de se sentir prolétarien, être un audiophile était aussi une volonté de ressentir, une volonté de ressentir que cela valait la peine d’avoir accès à une haute qualité sonore et à la possibilité de mettre du temps de côté pour l’utilisation de cet équipement.

– Pardon, mec, est-ce que je peux te poser une question ?

– Ben oui.

– Pourquoi vous, les ouvriers du bâtiment, êtes si ignorants ? Êtes-vous au courant des doctrines marxistes ?

– Oh ! ouais, un peu. Mais je pense qu’elles sont très anachroniques. Je préfère l’affirmation d’André Malraux selon laquelle le marxisme n’est pas une doctrine, mais une volonté, la volonté de ressentir le prolétariat. Passe-moi une autre brique.

C’est ainsi que nous avons atteint une sorte d’utopie technologique en matière de musique, et nous sommes entourés quotidiennement d’idées, de matériels qui impliquent des idées, et de matériels qui peuvent réaliser des idées – tout cela à des prix accessibles aux pauvres – ou tout au moins à un enseignant de la classe moyenne inférieure, même si sa situation économique va à reculons. C’est formidable. Ce qui n’est pas formidable, c’est que nous n’avons pas réalisé que dans le futur, il y aurait si peu de place pour nous qui travaillons dans le secteur des musiques expérimentales. Car ce qui n’a pas changé pour nous, depuis les années 1960, c’est la place que nous occupons – notre position par rapport au monde musical dans son ensemble. Comme l’a dit si éloquemment Ben Boretz[36] nous sommes à la « fine pointe d’un acte en voie de disparition »[37]. Nous sommes l’activité marginale d’un mastodonte économique. Et le mastodonte utilise nos découvertes, la plupart du temps sans les reconnaître.

Les mots que nous-mêmes utilisons ont continuellement été repris par différents styles. J’ai vu les termes de « new music », « musique expérimentale », « musique électronique », « musique minimaliste », et la liste est sans fin, utilisés par un genre pop ou par un autre au cours des dernières décennies sans qu’aucune reconnaissance concernant l’origine de ces termes ne soit exprimée. En fait, de nos jours, lorsque mes étudiants parlent de « musique contemporaine », ils ne font pas référence à nous. Ils pensent à la musique pop à laquelle ils s’intéressent actuellement. Nous, et nos travaux, avons été constamment « non définis » par l’industrie, la culture populaire et les médias.

« Soundbytes Magazine »[38] a été une petite publication web à laquelle j’ai contribué de 2008 à 2021 environ, avec des critiques de logiciels ou de livres. Le rédacteur en chef, Dave Baer, était impliqué dans l’informatique depuis les années 1960. Il a été technicien sur l’Illiac IV, puis il a rejoint le centre informatique de l’Université de Californie à San Diego. Il se souvient d’avoir été présent au concert à l’Université d’Illinois de HPSCHD de Cage et Hiller. C’est aussi un très bon vocaliste, qui a chanté dans les chœurs de productions d’opéra amateur. Nos démarches ne lui sont donc pas étrangères. En 2013, pour un numéro de Soundbytes, je lui ai proposé de réaliser une interview avec moi, puisque j’utilisais les ordinateurs d’une manière que je pensais être assez intéressante. Sa réponse m’a sidéré – il serait content de le faire, mais il faudrait probablement y inclure une introduction substantielle pour situer mon œuvre dans son contexte, puisque, ce que je faisais était si éloigné des intérêts grand public des concepteurs de l’informatique musicale ! En disant cela, il ne voulait pas dire, par exemple, que mon travail sur la micro-tonalité était très éloigné, disons, des démarches spectromorphologiques acousmatiques. Non, il voulait dire que mon travail, et toutes les autres choses que nous faisons, étaient très éloignés des compositeurs de dance-music amateurs travaillant dans leur chambre à coucher. C’est ainsi que, selon sa conception de la conscience populaire en 2013, même le terme qu’on utilisait pour nous décrire – « musicien informaticien » – ne s’appliquait plus à nous-même. Une fois de plus, la conscience populaire nous avait volé notre identité. C’est sans doute le prix à payer pour se situer aux confins des lisières sanglantes.

Bien évidemment, si l’on rend un outil accessible à « tout le monde », il est plus que probable qu’il va être utilisé pour faire quelque chose que les gens veulent faire, et pas nécessairement ce pour quoi on a envisagé l’utilisation de l’outil. Cela fait longtemps que ce phénomène existe. Je peux raconter une drôle d’histoire qui m’est arrivée à ce sujet. Au début des années 1970, à San Diego, je faisais partie d’un groupe appelé « Fatty Acid » qui jouait mal les pièces populaires de la musique classique. (Le groupe était dirigé par le violoncelliste et musicologue Ronald Al Robboy ; l’autre membre régulier du groupe était le compositeur, écrivain et interprète David Dunn). Il s’agissait d’un acte de comédie d’art conceptuel musicologique, avec de sérieuses connotations stravinskiennes néo classiques – ou peut-être de sérieuses prétentions spectromorphologiques stravinskiennes. Il faut imaginer quel impact fondamental Fatty Acid a eu sur mes démarches de compositeur et de performer. Par la suite, en 1980, j’ai découvert le Fairlight CMI. C’était le paradis. À partir de ce moment, j’étais capable de produire ma « musique incompétente » tout seul, sans avoir à retourner à San Diego de Melbourne pour jouer avec mes potes. Mon enthousiasme était total. Quand j’ai rencontré Peter Vogel et Kim Ryrie, les développeurs de Fairlight, je n’ai pas pu m’empêcher de leur jouer ma musique « de mauvais ensemble de blues amateur ». Ils n’ont pas été, c’est assez naturel, très impressionnés. Ce que je pensais être une utilisation naturelle et excitante de leur machine, était pour eux, bizarre, c’est tout. Je n’étais pas Stevie Wonder. Je me souviens d’Alvin Curran il y a bien longtemps, me disant que je devais faire attention à qui je faisais écouter certaines de mes productions les plus extravagantes. Pour mon plus grand malheur, ils ne faisaient pas partie de mon public cible idéal.

Ainsi, la pression exercée sur nous les gens bizarres, pour qu’on se conforme est toujours là, avec la même intensité. Il convient de remonter le temps et d’écouter ce que disait Mao Zedong en 1942, au Forum sur la littérature et l’art de Yenan. La langue est ici celle du marxisme doctrinaire, mais en substituant les termes, elle pourra paraître extrêmement contemporaine, bien qu’elle soit née à une autre époque et dans un monde idéologique très différent :

[Le premier problème est le suivant] : qui la littérature et l’art doivent-ils servir ? À vrai dire, ce problème a été depuis longtemps résolu par les marxistes, et en particulier par Lénine. Dès 1905, Lénine soulignait que notre art et notre littérature doivent « servir… les millions et les dizaines de millions de travailleurs » (…) Le problème : qui servir ? étant résolu, nous abordons maintenant le problème : comment servir ? Ou, comme le posent nos camarades, devons-nous consacrer nos efforts à élever le niveau de la littérature et de l’art ou bien à les populariser ? (…) Dans le passé, des camarades ont sous-estimé ou négligé dans une certaine mesure, et parfois dans une mesure importante, la popularisation de la littérature et de l’art. (…) Nous devons populariser seulement ce dont ont besoin les ouvriers, paysans et soldats et qu’ils sont prêts à accueillir.[39]

Si l’on substitue « public cible » à « ouvriers, paysans et soldats » et « produire quelque chose qu’on peut vendre » à « popularisation », il devient assez clair, peu importe que le système soit capitaliste ou communiste, qu’ils veulent tous que nous dansions à leur guise.

En 1970, Cornelius Cardew dans des perspectives marxistes-léninistes, nous a exhortés à « mettre nos pas du côté du peuple, et à produire de la musique qui serve à ses luttes »[40].

Aujourd’hui, la scène de la dance-music nous exhorte (à Melbourne) à mettre nos pas du côté du peuple et à produire de la musique qui serve ses luttes pour le groove.

Today, the film-music industry exhorts us to shuffle our feet over to the side of the industry and provide music which serves their narratives.

Aujourd’hui l’industrie de la musique de film nous exhorte à mettre nos pas du côté de l’industrie, et à produire de la musique qui serve à leurs narrations.

Eh bien, peut-être que nous n’avons pas envie de mettre nos pas dans ces engrenages. Peut-être que nous voulons rester ce que Kenneth Gaburo a appelé des « musiciens impertinents » [Irrelevant Musicians][41]. Peut-être que nous voulons être assez arrogants pour faire une musique qui exige ses propres offres et offre ses propres demandes. Je ne suis pas sûr d’être d’accord avec Gaburo lorsqu’il dit : « Si le monde entier va un jour se réveiller, il aura besoin de trouver quelque chose pour s’éveiller ». Je pense qu’un jour le monde entier fournira probablement les choses dont il a besoin pour son propre éveil. Mais je comprends où Gaburo veut en venir. Car en opposition à toute pensée orientée vers le marché, certains parmi nous considèrent la musique comme un cadeau, et non pas comme un prix de vente. Pendant les dernières années, Bandcamp a semblé être un lieu où les gens pouvaient créer une communauté qui s’intéressait en premier lieu à la musique comme moyens d’échange esthétique ou informationnel, et seulement accessoirement comme un produit du marché.

8. Conclusion

Ainsi, depuis longtemps nous étions dans l’opposition et nous le sommes toujours aujourd’hui. J’ai lu quelque part il y a peu une assertion qui m’a consterné. C’était quelque chose comme : « Toute position esthétique profondément ancrée n’est devenue aujourd’hui qu’un élément prédéfini de plus dans l’arsenal de possibilités utilisé pour la composition ». Quand dans le passé j’avais énoncé une réflexion un peu ironique sur le fait que, par exemple, la FM et l’algorithme Karplus-Strong, des choses auxquelles des forcenés du travail avaient consacré une partie substantielle de leur vie, étaient maintenant devenues juste des options de timbre dans le cadre du softsynth, ou bien des options dans un module de logiciel de synthèse, je m’attendais en quelque sorte à ce que les nouvelles idées technologiques soient absorbées dans le contexte plus large des techniques contemporaines. Mais cette remarque impliquait que les idées compositionnelles n’étaient que des ressources recyclables parmi d’autres, du grain à moudre pour la grande fabrique de saucisses post-moderne (ou de l’alter-moderne pour citer les critiques britanniques). C’est peut-être un peu vrai, mais c’est tout de même dérangeant.

Est-on alors réellement arrivé à une situation de démocratisation de nos outils par le biais de leur omniprésence ? Ou bien est-on en présence d’une quantité limitée de ressources, celles offertes par « l’industrie » qui ne vont pas faire dérailler le système 4/4 ? Je pense que la réponse est les deux à la fois. Les ressources sont là pour que les gens les utilisent. C’est à nous de continuer à rappeler aux gens quelles autres utilisations potentielles il y a à explorer et comment la nouvelle utopie technologique peut leur procurer les moyens d’exploration et même de transformation de soi. Pour réaliser cela, il faut probablement se battre (toi et moi, mon frère!) contre les médias qui veulent désavouer nos existences qui les dérangent. Mais cette lutte en vaut la peine, si l’on est capable de constituer l’un des nombreux groupes de personnes qui vont maintenir en vie les modes de pensée alternatives et transformationnelles, accessibles à ceux et celles qui ont la curiosité et le désir d’explorer.

Que nous reste-t-il ? Ce qui nous reste, c’est le travail. Le travail qui élargit notre conscience ; le travail qui offre les opportunités de changement de perception ; le travail qui tente de provoquer des changements dans la société ou qui met à disposition un modèle du type de société dans laquelle on veut vivre ; le travail qui réaffirme notre identité comme faisant partie de notre société de manière unique et utile. Le travail qu’on a besoin de retrouver de manière ininterrompue. Comme l’ont dit les Teen Age Mutant Ninja Turtles, ou était-ce Maxwell Smart ou bien Arnold Schoenberg ? – « C’est un sale boulot, mais quelqu’un doit le faire ».

Warren Burt, Nightshade Etudes 2012-2013 #19 – [Steinway à sourdine tomate]

Gamme micro-tonale basée sur l’œuvre d’Ery Wilson, « Moment of Symmetry »

Timbre – piano en sourdine de la synthé Pianoteq Physical Modeling

Modèles de protéines d’ADN de la banque de données génétiques du NIH

Logiciel de composition ADN – ArtWork par Algorithmic Arts

Studio de composition : trains de banlieue régionaux de la ligne V/Line, Victoria

Les motifs de protéine de l’ADN de tomates sont appliqués aux hauteurs, intensités, rythmes

et sont joués comme canon polyrythmique sur un Steinway virtuel en sourdine.

1.Merci à Guillaume Dussably et Gilles Laval pour leur relecture de la traduction française.

2. Cat Hope, compositrice, flûtiste et bassiste, crée des musiques conceptuelles, sous formes de partitions graphiques animées pour des combinaisons acoustiques et électroniques et pour des improvisations. Voir Cat Hope

3. Susan Frykberg (1954-2023) est une compositrice (Nouvelle Zélande) qui a vécu au Canada de 1979 à 1998. Voir wikipedia, Susan Frykberg

4. Joel Chadabe (1938-2021), compositeur (Etats-Unis), auteur et pionnier du développement des systèmes interactifs électroacoustiques. Voir wikipedia, Joel Chadabe

5. Le Center for Music Experiment était de 1972 à 1983 le centre de recherche attaché au département de musique de l’Université de Californie San Diego.

6. Un PDP-11, voir wikipedia PDP-11.

7. Ed Kobrin, un pionnier de la musique électronique (Etats-Unis). Il avait créé un système hybride très sophistiqué : Hybrid I-V. openlibrary Ed Kobrin.

8. Les synthétiseurs Serge ont été créés par Serge Tcherepnine, un compositeur et fabricant d’instruments de musique électronique : wikipedia Serge Tcherepnine. Voir aussi : radiofrance: Archéologie du synthétiseur Serge Modular

9. Célèbre plage nudiste à proximité de UCSD. Voir wikipedia

10. Kenneth Gaburo (1926-1993), compositeur (Etats-Unis). A l’époque mentionnée dans cet article, il était professeur au département de musique à UCSD. Voir wikipedia Kenneth Gaburo

11. Catherine Schieve est une artiste intermédia, compositrice et autrice. Elle vit près d’Ararat, dans le centre de l’État de Victoria (Australie). Voir astramusic.org; et rainerlinz.net

12. Il s’agit du New England Digital Synthesizer – une première version de ce qui deviendra le Synclavier, et le Quasar M-8 – qui deviendra le Fairlight CMI

13. Georgina Born, Rationalizing Culture, IRCAM, Boulez and the Institutionalization of the Musical Avant-Garde, Berkley – Los Angeles – London : University of California Press, 1995.

14. George Lewis, compositeur, performer, et chercheur en musique expérimentale, professeur à l’Université Columbia, New York. wikipedia George Lewis

15. Graham Hair, compositeur et chercheur (Australie). Voir wikipedia Graham Hair

16. Stanley Lunetta (1937-2016), percussionniste, compositeur, et sculpteur (Californie).

17. Ron Nagorcka, compositeur, il joue du didgeridoo and des claviers (Australie). Voir wikipedia Ron Nagorcka

18. Ernie Althoff, musicien, compositeur, constructeur d’instruments et artiste plasticien (Australie). Voir wikipedia Ernie Althoff

19. Graeme Davis, musicien, et performance artiste. daao.org.au Graeme Davis

20. Alvin Lucier (1931-2021), compositeur (Etats-Unis). Voir wikipedia Alvin Lucier et pour I am sitting in a room: youtube

21. Joel Chadabe avait commencé à travailler avec le New England Digital Synthesizer, et avec Roger Meyers, il avait développé un logiciel appelé Play2D pour le contrôler.

22. Tristam Cary ‘1925-2008), compositeur, pionnier de la musique électronique et musique concrète en Angleterre, puis en Australie. Voir wikipedia Tristam Cary

23. George Lewis à New York m’avait montré ses travaux avec le AIM-65de Rockwell et il m’avait parlé du langage FORTH. Un peu plus tard Serge Tcherepnin m’a donné la puce qui faisait tourner FORTH. Cela m’a amené à me lancer sérieusement, peut-être la première fois, dans la programmation informatique .

24. Mon ordinateur était un Rockwell AIM-65 qui comportait trois horloges, toutes décomptées à partir d’une source commune. On pouvait entrer des nombres dans chaque horloge et cela produisait des sous-harmoniques (diviseurs) de l’horloge principale qui fonctionnait à approximativement 1 MHZ. Ce système pouvait être facilement mis en interface avec mon synthétiseur Serge./p>

25. Les trois horloges/oscillateurs du AIM étaient alors traités par les circuits analogiques du Serge.

26. Harry Partch (1901-1974), compositeur et constructeur d’instruments (Etats-Unis). Voir wikipedia Harry Partch

27. St Kilda est un quartier de Melbourne (Australie).

28. Arun Chandra, compositeur et chef d’orchestre. Voir evergreen.edu Arun Chandra

29. Herbert Brün: wikipedia Herbert Brün.

30. Gottfried Michael Koenig (1926-2021), compositeur germano-néerlandais. Voir wikipedia Gottfried Michael Koenig

31. William Burroughs, The Green Nun : youtube The Green Nun

32. Le système AUMI est conçu pour être utilisé par n’importe qui à n’importe quel niveau de compétence – en fonction de la manière de programmer ce système, l’utilisateur peut le jouer à n’importe quel niveau de sa capacité physique. Voir AUMI

33. David Dunn, courriel à Warren Burt, à la fin de 2014.

34. Deux tablettes basées sur Android, deux basées sur iOS, et une tablette Windows 8 en mode Bureau.

35. Harry Partch: “The Spiritual Corporeal nature of man” tiré de “Harry Partch in Prologue” sur le disque bonus de la “Delusion of the Fury”, Columbia Masterworks – M2 30576 · 3 x Vinyl, LP. Box Set · US · 1971.

36. Ben Boretz, compositeur et théoricien de la musique (Etats-Unis). Voir paalabres.org Ben Boretz

37. Ben Boretz, If I am a Musical Thinker, Station Hill Press, 2010.

38. Soundbytes Magazine et Dave Baer (rédacteur en chef) : Depuis que cet article a été écrit et révisé, toutes les références au magazine Soundbytes ont disparu du web. J’espère publier une compilation des critiques que j’ai écrites pour ce magazine sur mon site www.warrenburt.com à la fin de l’année 2024.

39. Mao Zedong : Interventions sur l’art et la littérature. Mai 1942. materialisme-dialectique